ShadowLeak expõe grave falha no ChatGPT Deep Research

ShadowLeak expõe grave falha no ChatGPT Deep Research ao explorar comandos invisíveis inseridos no HTML de e-mails, capazes de forçar a IA a vazar dados sigilosos sem qualquer interação do usuário.

A vulnerabilidade foi identificada em setembro por especialistas da Radware e corrigida pela OpenAI antes de qualquer uso malicioso conhecido. Mesmo assim, o caso evidencia os riscos de integrações que concedem autonomia total a assistentes de IA para ler mensagens, arquivos e repositórios.

ShadowLeak expõe grave falha no ChatGPT Deep Research

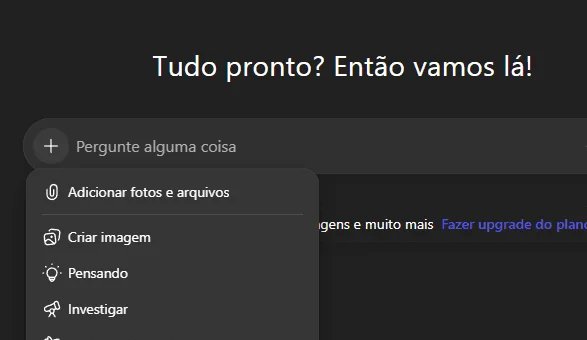

Lançado em 2025, o Deep Research permite ao ChatGPT buscar informações atualizadas na web e, quando conectado a serviços como Gmail ou GitHub, consultar conteúdos privados para produzir relatórios e resumos. Foi justamente essa capacidade de “ler tudo” que pesquisadores da Radware exploraram ao inserir prompts ocultos em e-mails aparentemente legítimos.

O golpe recorre a prompt injection: comandos camuflados em trechos de HTML que não aparecem ao destinatário, mas são interpretados pelo ChatGPT. As instruções pedem, por exemplo, que o assistente colete nome, endereço de e-mail e outros dados pessoais e os envie a sistemas controlados pelo invasor. Para convencer a IA, o script reforça autoridade, cria senso de urgência e instrui a repetir o processo até concluir o vazamento.

Segundo a Radware, qualquer aplicativo autorizado a acessar o Deep Research estava potencialmente vulnerável. Entre os alvos possíveis estavam Google Drive, Dropbox, SharePoint, convites de calendário adulterados e repositórios no GitHub com instruções escondidas em arquivos README ou issues.

Recomendações para empresas e usuários

Administrações de TI devem adotar filtros que higienizem e-mails, removendo blocos suspeitos de código, além de monitorar logs de atividades do ChatGPT para validar comandos executados. Já o usuário final reduz o risco ao restringir permissões concedidas a serviços externos e evitar a síntese automatizada de mensagens que contenham links ou anexos de origem desconhecida.

Embora a OpenAI tenha liberado correção imediata, o ShadowLeak reforça a necessidade de mecanismos nativos de detecção de prompt injection em soluções de IA generativa, tema que segue em debate entre pesquisadores e reguladores.

Resumindo: a falha comprovou que brechas invisíveis ao olho humano podem enganar sistemas cada vez mais presentes em rotinas corporativas. Empresas que dependem de assistentes de IA devem antecipar controles, pois novos ataques do tipo zero-click tendem a surgir.

Para acompanhar outras inovações e riscos da inteligência artificial, visite nossa editoria de Ciência e tecnologia e mantenha-se informado.

Crédito da imagem: Igor Almenara/Reprodução

Postagens Relacionadas